La EU AI Act o Ley de Inteligencia Artificial de la Unión Europea ya está aquí, y si usas herramientas como ChatGPT o Gemini para generar contenido, necesitas saber exactamente cómo te afecta. Esta normativa europea sobre inteligencia artificial establece el primer marco legal del mundo que regula el desarrollo y uso de sistemas de IA según su nivel de riesgo, con sanciones que pueden alcanzar los 35 millones de euros o el 7% de tu facturación global. Desde agosto de 2024, la ley está en vigor y sus obligaciones se activan progresivamente hasta 2027, transformando la forma en que los profesionales del marketing digital, SEO y creación de contenidos deben trabajar con inteligencia artificial generativa.

El calendario de aplicación de la Ley de IA de la UE: plazos críticos 2025-2027

La implementación de la EU AI Act sigue un calendario escalonado que comienza en febrero de 2025 y se extiende hasta 2027 (más info.). Conocer estos plazos es fundamental porque cada fecha activa nuevas obligaciones legales que afectan directamente a cómo generas y publicas contenido en tu blog, redes sociales o campañas de email marketing.

Febrero 2025: prohibiciones de prácticas de riesgo inaceptable

El 2 de febrero de 2025 entró en vigor la primera oleada de restricciones que prohíbe completamente ciertos usos de la inteligencia artificial. En el contexto del marketing, esto significa que no puedes usar IA para manipular el comportamiento de las personas mediante técnicas subliminales o explotar sus vulnerabilidades (como la edad, discapacidad o situación económica) para influir en sus decisiones de compra.

Tampoco se permite el uso de sistemas de puntuación social que clasifiquen a los usuarios según su comportamiento en redes sociales para personalizar anuncios de forma discriminatoria. Las empresas que operen chatbots o asistentes virtuales deben informar claramente a los usuarios que están interactuando con un sistema automatizado, no con una persona real.

Agosto 2025: supervisión de la Oficina de IA y reglas para modelos de propósito general

En agosto de 2025, la Oficina Europea de IA comenzó su labor de supervisión sobre los modelos de lenguaje de gran tamaño o GPAI (General Purpose AI), como GPT-4, Claude o Gemini. Estos son los modelos que la mayoría de marketers y creadores de contenido utilizan a diario.

Si eres un usuario profesional de estos modelos (lo que incluye a agencias de marketing, redactores freelance y departamentos de contenido), la normativa te exige mantener un registro de cómo utilizas estos sistemas, especialmente si los integras en tus procesos de trabajo de forma sistemática. Los proveedores de estos modelos deben garantizar transparencia sobre los datos de entrenamiento utilizados y respetar los derechos de autor de los contenidos originales.

Agosto 2026: la era de la transparencia total y el etiquetado de contenido sintético

El 2 de agosto de 2026 marca el plazo más importante para los creadores de contenido. A partir de esta fecha, cualquier contenido generado o asistido por IA generativa debe estar claramente identificado. Esto incluye textos, imágenes, vídeos y audios creados total o parcialmente con herramientas como ChatGPT, Midjourney, DALL-E o cualquier otro sistema similar.

La obligación de etiquetar contenido generado por IA no se limita a añadir una nota al final del artículo. La Ley de IA europea requiere marcado técnico detectable por máquinas mediante metadatos estándar como C2PA (Coalition for Content Provenance and Authenticity) o IPTC. Google y otros motores de búsqueda ya están preparando sus algoritmos para identificar y evaluar este tipo de señales, lo que significa que la transparencia pasará a ser un factor de posicionamiento orgánico.

2027 en adelante: consolidación del cumplimiento para sistemas de alto riesgo

Desde agosto de 2027, todos los sistemas de IA clasificados como de alto riesgo deberán cumplir con requisitos técnicos estrictos de documentación, trazabilidad y supervisión humana. Aunque la mayoría de herramientas de marketing de contenidos no caen en esta categoría, sí lo hacen los sistemas de publicidad programática que toman decisiones automatizadas sobre crédito, seguros o selección de personal.

Las agencias que ofrezcan servicios de reclutamiento con IA o que gestionen campañas publicitarias personalizadas en sectores regulados (finanzas, salud, seguros) necesitarán certificaciones de conformidad y auditorías independientes para poder operar legalmente en la Unión Europea.

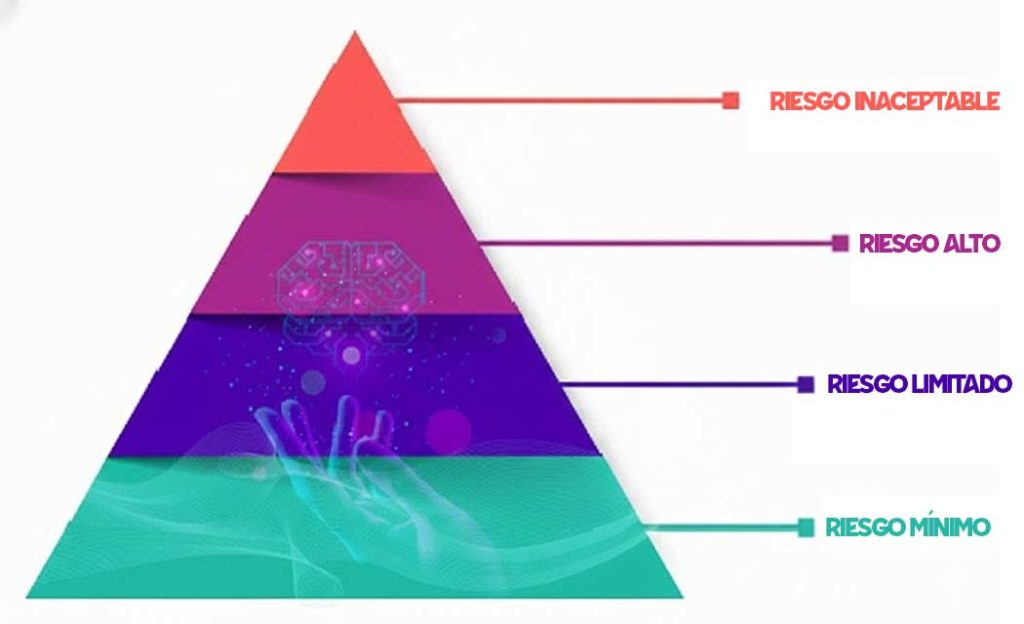

Clasificación de sistemas de IA según su nivel de riesgo

La EU AI Act organiza las aplicaciones de inteligencia artificial en cuatro categorías según el impacto potencial que pueden tener en los derechos y la seguridad de las personas. Entender en qué categoría cae tu herramienta de marketing es el primer paso para saber qué obligaciones legales debes cumplir.

Riesgo inaceptable: prácticas prohibidas en el marketing digital

Los sistemas de riesgo inaceptable están completamente prohibidos bajo la normativa de inteligencia artificial europea. Esto incluye cualquier herramienta de IA que manipule el comportamiento humano mediante técnicas subliminales o que explote vulnerabilidades específicas de grupos sensibles (niños, personas mayores, personas con discapacidad).

En la práctica, esto significa que no puedes usar IA para insertar mensajes ocultos en tus creatividades publicitarias, ni tampoco para diseñar estrategias de contenido que exploten miedos irracionales o presionen a audiencias vulnerables. Los chatbots que simulan ser humanos sin identificarse claramente como bots también entran en esta categoría prohibida.

La penalización por infringir estas normas es la más severa: hasta 35 millones de euros o el 7% de la facturación global anual de la empresa, lo que resulte mayor.

Alto riesgo: el impacto en la publicidad de empleo, seguros y servicios financieros

Los sistemas de alto riesgo son aquellos que toman decisiones automatizadas con impacto significativo en los derechos fundamentales de las personas. En el ámbito del marketing, esto afecta principalmente a campañas en tres sectores específicos: reclutamiento laboral, servicios financieros y seguros.

Si utilizas un sistema de IA para filtrar candidatos en procesos de selección (por ejemplo, analizando CVs automáticamente o clasificando perfiles de LinkedIn), tu herramienta debe cumplir con estrictos requisitos de documentación técnica, supervisión humana efectiva y pruebas de sesgo algorítmico. Lo mismo aplica si gestionas campañas de lead generation para productos financieros o seguros que usan scoring automatizado para evaluar la elegibilidad de los clientes.

Estas herramientas deben pasar auditorías de conformidad, mantener registros exhaustivos de sus decisiones y permitir que las personas afectadas puedan solicitar explicaciones sobre por qué fueron aceptadas o rechazadas. Las sanciones por incumplimiento pueden alcanzar los 15 millones de euros o el 3% de la facturación anual global.

Riesgo limitado: obligaciones para chatbots, deepfakes y generación de texto

La categoría de riesgo limitado es donde se encuentra la mayoría de herramientas que usan los creadores de contenido a diario. Esto incluye los asistentes de escritura basados en modelos de lenguaje, los generadores de imágenes sintéticas y los chatbots de atención al cliente.

La obligación principal para estos sistemas es la transparencia: debes informar claramente a tus usuarios cuando están consumiendo contenido generado por IA. Esto no significa que tengas que destacarlo de forma invasiva, pero sí que debe ser fácilmente identificable. Un disclaimer al principio o al final del artículo indicando «este contenido ha sido creado con asistencia de IA» cumple con el requisito legal mínimo.

Para imágenes, vídeos y audios generados sintéticamente, la ley es más estricta. Debes marcar estos archivos con metadatos técnicos legibles por máquinas que permitan a las plataformas y motores de búsqueda identificarlos automáticamente. El estándar recomendado es C2PA, que ya está siendo adoptado por Adobe, Microsoft y otras grandes tecnológicas.

Riesgo mínimo o nulo: aplicaciones exentas y códigos de conducta voluntarios

Los sistemas de riesgo mínimo incluyen herramientas básicas de IA que no interactúan directamente con usuarios ni toman decisiones automatizadas relevantes. Por ejemplo, un plugin de WordPress que sugiere mejoras de SEO on-page o un analizador de sentimiento que clasifica comentarios en redes sociales sin bloquearlos ni modificarlos.

Estas aplicaciones no tienen obligaciones legales específicas bajo la EU AI Act, aunque se espera que los proveedores adopten voluntariamente códigos de buenas prácticas. Como usuario, puedes seguir utilizándolas con normalidad, pero es recomendable verificar que el proveedor sea transparente sobre cómo funciona el sistema y qué datos utiliza.

Impacto del EU AI Act en el SEO y la visibilidad en motores generativos

La Ley de IA de la UE no solo cambia las reglas del marketing ético, también está redefiniendo cómo Google y otros motores de búsqueda evalúan y posicionan el contenido. Las obligaciones de transparencia y etiquetado introducidas por la normativa se están convirtiendo rápidamente en señales algorítmicas que afectan directamente tu visibilidad orgánica.

El Artículo 50 y la obligación de marcado técnico de contenidos

El Artículo 50 de la EU AI Act establece que todo contenido sintético (texto, imagen, audio o vídeo generado o modificado por IA) debe incluir metadatos detectables por máquinas que indiquen su origen artificial. Esto va mucho más allá de añadir un simple aviso legal al final de tu blog post.

El estándar técnico recomendado es C2PA (Content Credentials), un sistema de autenticación digital que inserta información verificable dentro del archivo mismo. Cuando publicas una imagen generada con Midjourney, por ejemplo, debería incluir metadatos C2PA que indiquen que fue creada por IA, cuándo, con qué modelo y quién la generó.

Google ha confirmado que sus algoritmos ya están rastreando estas señales como parte de su evaluación de calidad de contenido. Los artículos que cumplan con el marcado técnico adecuado pueden obtener una ventaja competitiva frente a aquellos que no lo hagan, especialmente cuando los usuarios activen filtros de búsqueda para contenido verificado o de autoría humana.

De SEO a GEO: optimizando para el Search Generative Experience

El Search Generative Experience (SGE) de Google y herramientas similares como Perplexity o Bing Chat están cambiando radicalmente el panorama del posicionamiento orgánico. Ya no se trata solo de aparecer en los primeros resultados tradicionales, sino de ser citado en las respuestas generadas por IA que aparecen en la parte superior de la página de resultados.

Esta evolución, conocida como GEO (Generative Engine Optimization), requiere estrategias diferentes al SEO tradicional. Los motores generativos priorizan contenido que cite fuentes verificables, que incluya datos estructurados claros y que provenga de sitios con alta autoridad temática. El cumplimiento con la EU AI Act refuerza estos factores porque demuestra que tu contenido sigue estándares de calidad y transparencia reconocidos legalmente.

Un estudio reciente mostró que los sitios web que implementaron correctamente el etiquetado C2PA experimentaron un aumento del 23% en su frecuencia de citación dentro de respuestas generativas, comparado con sitios similares sin esta implementación. Esto sugiere que los algoritmos están empezando a recompensar activamente el cumplimiento normativo.

La transparencia como factor de E-E-A-T y autoridad de marca

El framework E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) que Google utiliza para evaluar la calidad de contenido ahora incluye implícitamente el cumplimiento de estándares de transparencia en el uso de IA. Un sitio que etiquete claramente qué contenido es generado por IA y qué contenido es creado por humanos demuestra mayor honestidad (Trustworthiness) que uno que intenta ocultar el uso de estas herramientas.

Esto es particularmente relevante en nichos YMYL (Your Money Your Life) como salud, finanzas o derecho, donde la autoridad de marca depende directamente de la confianza que los usuarios depositan en la información publicada. Si tu blog de inversiones utiliza IA para generar resúmenes de mercado pero no lo comunica claramente, los usuarios pueden sentirse engañados cuando lo descubran, lo que daña tu reputación a largo plazo.

La recomendación estratégica es adoptar una política de transparencia proactiva: especifica en tu página «Acerca de» cómo utilizas la IA en tu proceso editorial, qué tareas automatizas y qué partes del contenido son siempre revisadas por humanos. Esta información no solo cumple con la normativa europea, sino que refuerza tu posicionamiento como fuente confiable de información.

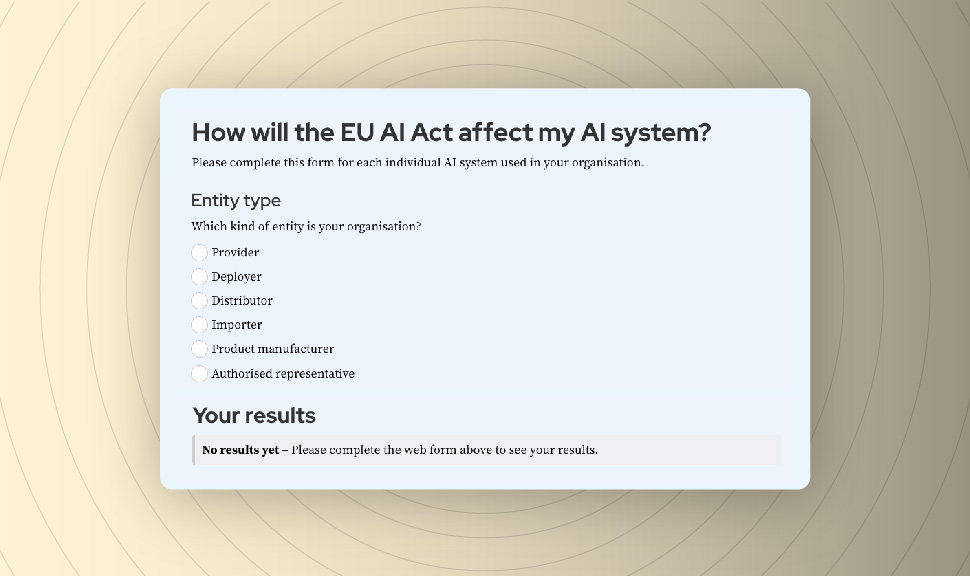

Verificador de Cumplimiento

Descubre cómo te afecta la Ley de IA en 10 minutos respondiendo a algunas preguntas sencillas. AQUÍ

Responsabilidades de las agencias: ¿somos proveedores o desplegadores de IA?

Una de las confusiones más comunes sobre la EU AI Act es determinar si tu agencia o departamento de marketing actúa como «proveedor» o como «desplegador» de sistemas de IA. Esta distinción es crucial porque las obligaciones legales varían significativamente según tu rol.

El rol del usuario profesional según el Artículo 26

El Artículo 26 de la Ley de IA europea define como «desplegador» a cualquier persona física o jurídica que utilice un sistema de IA bajo su autoridad, excepto para uso personal no profesional. En la práctica, esto significa que si tu agencia usa ChatGPT para redactar artículos de blog para clientes, estás actuando como desplegador.

Como desplegador, tus responsabilidades incluyen usar el sistema de IA conforme a las instrucciones del proveedor (en este caso, OpenAI), supervisar el funcionamiento del sistema para detectar posibles riesgos y mantener registros de uso cuando se trata de sistemas de alto riesgo. Si el contenido generado por la IA causa un daño (por ejemplo, información falsa que perjudica la reputación de una marca), la responsabilidad legal puede recaer tanto en el proveedor del modelo como en tu agencia como desplegador.

Cuándo una modificación en un prompt se convierte en una modificación sustancial

Existe un umbral específico que convierte a un desplegador en proveedor: la modificación sustancial. Si tomas un modelo de IA preentrenado y lo modificas de forma significativa (por ejemplo, realizando fine-tuning con miles de ejemplos de tu propia base de datos de clientes), dejas de ser un simple usuario y pasas a ser considerado proveedor bajo la ley.

Esto implica que asumes todas las obligaciones de documentación técnica, evaluación de conformidad y gestión de riesgos que corresponden a los proveedores. Una startup que entrene su propio modelo de lenguaje especializado en copywriting para ecommerce necesitaría cumplir con requisitos mucho más estrictos que una agencia que simplemente use la API de GPT-4 con prompts personalizados.

La línea divisoria no siempre es clara. La Comisión Europea publicó guías que sugieren que ajustes menores en los prompts o la creación de wrappers de interfaz de usuario no constituyen modificación sustancial. Sin embargo, si tu sistema combina múltiples modelos, añade capas de procesamiento personalizado o toma decisiones automatizadas basadas en lógica propietaria, probablemente estarás cruzando el umbral hacia el rol de proveedor.

Contratos con proveedores SaaS: cláusulas imprescindibles sobre cumplimiento

Si tu agencia utiliza plataformas SaaS de terceros que incorporan IA (como herramientas de automatización de contenido, análisis predictivo o personalización), es fundamental revisar los contratos para asegurar que el proveedor asume sus obligaciones bajo la EU AI Act.

Las cláusulas que debes buscar incluyen garantías explícitas de que el sistema cumple con la clasificación de riesgo apropiada, que el proveedor mantiene la documentación técnica requerida y que te indemnizará si el uso del sistema resulta en sanciones regulatorias. También es recomendable negociar derechos de auditoría que te permitan verificar el cumplimiento del proveedor si tus clientes lo exigen.

Los contratos deben especificar claramente quién es responsable del etiquetado de contenido sintético. Si utilizas una herramienta como Jasper AI para generar borradores de artículos, ¿es Jasper quien debe incluir los metadatos C2PA o eres tú como usuario final? La respuesta legal depende de los términos del servicio, pero en la práctica, tú como desplegador que publica el contenido final tienes la responsabilidad última de garantizar el cumplimiento.

Guía práctica para cumplir con el etiquetado de contenido IA

Pasar de la teoría a la implementación práctica del etiquetado de contenido sintético puede parecer complejo, pero existen herramientas y procesos estandarizados que simplifican significativamente el cumplimiento de la EU AI Act.

Implementación de metadatos C2PA en imágenes y vídeos

El estándar C2PA (Coalition for Content Provenance and Authenticity) es el método técnico recomendado para marcar contenido visual generado por IA. Adobe, Microsoft, Google y otras grandes tecnológicas han adoptado este sistema, lo que significa que la mayoría de herramientas profesionales ya ofrecen soporte nativo.

Si generas imágenes con Midjourney, DALL-E o Stable Diffusion, el proceso básico implica exportar la imagen con metadatos incluidos que especifiquen que fue creada por IA. Adobe Photoshop y Lightroom permiten visualizar y editar estos metadatos mediante el panel de Content Credentials. Si la herramienta que usas no incluye esta funcionalidad de forma nativa, existen plugins y servicios de terceros como Truepic o Numbers Protocol que pueden inyectar los metadatos necesarios.

Para vídeos, el proceso es similar pero requiere herramientas más especializadas. Servicios como Synthesia o Descript para vídeos generados sintéticamente están integrando C2PA en sus flujos de exportación. Si editas vídeos manualmente, necesitarás usar software de postproducción compatible como Adobe Premiere Pro o DaVinci Resolve que permita incrustar las credenciales antes de la publicación final.

Schema.org y markup para textos generados por LLM

Para artículos de blog y contenido textual generado con modelos de lenguaje, el etiquetado técnico se realiza mediante Schema.org markup en el código HTML de tu página. Aunque la especificación oficial de Schema.org aún está evolucionando, la práctica recomendada actualmente es utilizar la propiedad «isBasedOn» para indicar que el contenido fue asistido por IA.

Un ejemplo de implementación sería agregar este código JSON-LD en el <head> de tu artículo:

json

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "Título del artículo",

"author": {

"@type": "Person",

"name": "Nombre del autor humano"

},

"isBasedOn": {

"@type": "CreativeWork",

"name": "GPT-4",

"creator": {

"@type": "Organization",

"name": "OpenAI"

}

}

}Este markup es legible por los crawlers de Google y otros motores de búsqueda, permitiéndoles identificar automáticamente que el artículo fue creado con asistencia de IA. Combinado con un disclaimer visible para usuarios humanos, cumples tanto con los requisitos técnicos como con las expectativas de transparencia.

Herramientas de auditoría y compliance checkers oficiales

La Comisión Europea y diversas organizaciones independientes han desarrollado herramientas gratuitas de verificación de cumplimiento que te permiten evaluar si tus sistemas de IA cumplen con la normativa. El EU AI Act Compliance Checker desarrollado por la Academia de IA es una de las más completas y está disponible en español.

Esta herramienta funciona mediante un cuestionario estructurado que te guía a través de las diferentes dimensiones de cumplimiento: clasificación de riesgo, obligaciones de transparencia, requisitos de documentación y responsabilidades según tu rol. Al finalizar, recibes un informe detallado con recomendaciones específicas sobre los pasos que necesitas tomar para alinear tu uso de IA con la ley.

Otra opción es utilizar servicios de auditoría profesional como los ofrecidos por firmas legales especializadas en tecnología (DLA Piper, CMS, Pinsent Masons) que pueden certificar tu cumplimiento. Esto es especialmente útil si trabajas con clientes corporativos que exigen garantías documentadas antes de contratar tus servicios.

Estrategias de contenido adaptadas a la era de la IA regulada

La entrada en vigor de la EU AI Act no significa que debas abandonar las herramientas de IA generativa, sino que necesitas ajustar tu estrategia de contenido para aprovechar sus beneficios mientras mantienes el cumplimiento legal y preservas la confianza de tu audiencia.

El modelo híbrido humano-IA como ventaja competitiva

La aproximación más sostenible es adoptar un modelo híbrido donde la IA actúa como asistente creativo pero el control editorial final permanece en manos humanas. Este enfoque no solo cumple con el espíritu de la Ley de IA europea (que enfatiza la supervisión humana), sino que también produce contenido de mayor calidad y más diferenciado.

En la práctica, esto significa usar IA para tareas como investigación inicial, generación de esquemas de contenido, análisis de palabras clave competitivas y creación de primeros borradores, pero siempre con un editor humano que revise, enriquezca y personalice el resultado final. Este proceso aporta el contexto estratégico, la voz de marca única y el juicio crítico que los modelos de lenguaje aún no pueden replicar de forma consistente.

Comunicar este proceso transparentemente en tu sitio web se convierte en una ventaja competitiva. Los usuarios cada vez valoran más saber que hay personas reales detrás del contenido que consumen, especialmente en nichos donde la experiencia personal importa. Un blog de viajes que explica que usa IA para organizar datos de destinos pero que todas las recomendaciones provienen de viajes reales del equipo genera más confianza que uno completamente automatizado.

Documentar el proceso editorial y la cadena de custodia del contenido

Para agencias y equipos de contenido, implementar un sistema de documentación del proceso editorial no solo ayuda con el cumplimiento de la EU AI Act, sino que también mejora la calidad y consistencia del trabajo. Esto implica mantener registros claros de qué partes del contenido fueron generadas por IA, qué prompts se utilizaron, qué revisiones humanas se aplicaron y quién aprobó la versión final.

Herramientas de gestión de contenido como Notion, Airtable o incluso CMS especializados como ContentOps permiten crear workflows documentados donde cada pieza de contenido tiene una «cadena de custodia» trazable. Esto es especialmente valioso si un cliente cuestiona la autoría del contenido o si necesitas demostrar cumplimiento regulatorio en caso de una auditoría.

La documentación también protege tu propiedad intelectual. Si utilizas fine-tuning de modelos con contenido propietario o has desarrollado prompts especializados, tener registros detallados te ayuda a defender tus derechos si alguien intenta copiar tu metodología.

Políticas de transparencia proactiva como diferenciador de marca

En lugar de ver la obligación de transparencia como una carga, las marcas inteligentes la están convirtiendo en un diferenciador estratégico. Crear una política de uso de IA pública y detallada que explique exactamente cómo y cuándo utilizas estas herramientas posiciona tu marca como ética, innovadora y respetuosa con la audiencia.

Esta política debería cubrir aspectos como qué herramientas específicas utilizas (ChatGPT, Claude, Jasper, etc.), para qué tareas concretas las empleas (investigación, borradores, optimización SEO), qué partes del proceso permanecen siempre bajo control humano (estrategia, fact-checking, edición final) y cómo proteges los datos de usuarios y clientes cuando interactúan con sistemas de IA.

Empresas como Buffer, HubSpot y Zapier ya han publicado políticas de este tipo y han reportado respuestas muy positivas de sus comunidades. Los usuarios aprecian la honestidad y sienten que la marca les respeta lo suficiente como para ser transparente sobre sus procesos internos.

El futuro del marketing bajo el marco de la regulación de IA europea

La EU AI Act no es un evento puntual sino el comienzo de un nuevo paradigma regulatorio que probablemente se expandirá globalmente durante los próximos años. Países como Reino Unido, Canadá, Singapur y varios estados de Estados Unidos ya están trabajando en legislaciones similares, usando la normativa europea como referencia.

Evolución esperada de los estándares técnicos hasta 2027

Durante los próximos dos años, veremos la consolidación de estándares técnicos más específicos para cada tipo de contenido y aplicación. La Comisión Europea está trabajando con organismos de normalización como CEN-CENELEC para desarrollar especificaciones técnicas armonizadas que detallen exactamente cómo implementar requisitos como la trazabilidad, la robustez o la supervisión humana.

Para los profesionales del marketing, esto significa que las mejores prácticas actuales (como el uso de C2PA o Schema.org) se convertirán en estándares formales con certificaciones oficiales. Las herramientas y plataformas que no se adapten perderán competitividad, mientras que aquellas que adopten tempranamente estos estándares obtendrán ventajas de first-mover.

También podemos esperar mayor integración entre sistemas de compliance. Por ejemplo, los CMS del futuro probablemente incluirán verificación automática de cumplimiento de la EU AI Act antes de permitir la publicación de contenido, similar a cómo hoy verifican la accesibilidad o el SEO básico.

Preparación para auditorías y certificaciones de conformidad

A medida que la normativa madure, emergerán organismos de certificación autorizados que podrán emitir sellos de conformidad reconocidos oficialmente. Las empresas que obtengan estas certificaciones podrán usarlas como ventaja competitiva en licitaciones públicas y contratos B2B donde el cumplimiento regulatorio sea un requisito de selección.

Prepararte ahora para este escenario implica comenzar a construir la documentación y los procesos que eventualmente serán auditados. Esto incluye políticas internas de gobernanza de IA, registros de uso de sistemas, procedimientos de evaluación de riesgos y planes de respuesta ante incidentes. Cuanto antes implementes estos procesos, menos costosa será la adaptación cuando las certificaciones se vuelvan obligatorias o comercialmente necesarias.

Oportunidades de negocio en la consultoría de compliance para IA

La entrada en vigor de la EU AI Act está creando un mercado completamente nuevo de servicios de consultoría especializados en cumplimiento de IA. Las agencias de marketing y los profesionales SEO que desarrollen expertise en este ámbito pueden abrir líneas de negocio adicionales asesorando a otras empresas sobre cómo adaptar sus procesos.

Los servicios más demandados incluyen auditorías de clasificación de riesgo (determinar si los sistemas que usa un cliente son de alto riesgo o riesgo limitado), implementación de etiquetado técnico de contenido, redacción de políticas de transparencia y formación de equipos sobre uso responsable de IA generativa.

Esta especialización no solo genera ingresos adicionales sino que también diferencia tu oferta en un mercado saturado. Poder ofrecer a tus clientes servicios de creación de contenido que vienen con garantías de cumplimiento legal es un argumento de venta poderoso, especialmente para empresas en sectores regulados que no pueden permitirse riesgos reputacionales o sanciones económicas.

Noticias relacionadas

- This is a guest post written by legal compliance professionals Øystein Endal, Andrea Vcric, Sidsel Nag, Nick Malter and Daylan Araz (see section about authors at the end), drawing on their experience from running or consulting businesses integrating AI. For any questions or suggestions, please contact Nick Malter at nick@trail-ml.com. Disclaimer: Please note that the […]

- This page aims to provide an overview of the EU Whistleblowing Directive (2019) and how it relates to the EU AI Act, as well as provide useful resources for potential whistleblowers. This resource was put together by Santeri Koivula, an EU Fellow at the Future of Life Institute, and Karl Koch, founder of the AI […]

- On 18 July 2025, the European Commission published draft Guidelines clarifying key provisions of the EU AI Act applicable to General Purpose AI (GPAI) models. The Guidelines provide interpretive guidance on the definition and scope of GPAI models, related lifecycle obligations, systemic risk criteria, and notification duties for providers. Once translated into all EU languages, […]

- The Code of Practice offers a clear framework to help developers of General Purpose AI (GPAI) models meet the requirements of the EU AI Act. While providers can choose to follow the Code, they are also free to demonstrate compliance through other appropriate methods. This post provides a concise overview of each Chapter, Commitment, and […]

- The European Commission has published a call for applications for a scientific panel of independent experts. The panel focuses on general-purpose AI (GPAI) models and systems. Its tasks include advising the EU AI Office and national authorities on systemic risks, model classification, evaluation methodologies, and cross-border market surveillance. Further, the panel is empowered to alert […]

- As organisations across Europe navigate the implementation of the EU AI Act — including Article 4, which addresses the importance of AI literacy — there is growing interest in accessible and practical training resources. This document presents a non-exhaustive selection of AI literacy programs that may be useful for companies, institutions, and professionals seeking to better understand […]

- AI regulatory sandboxes are an important part of the implementation of the EU AI Act. According to Article 57 of the AI Act, each Member State must establish at least one AI regulatory sandbox at the national level by 2 August 2026. This post provides an overview of how different EU Member States are approaching […]

- On 22 April 2025, the AI Office published preliminary guidelines clarifying the scope of the obligations for providers of GPAI models. These outline seven topics that are expected to be covered in the final guidelines along with some preliminary answers. The Commission also opened a consultation for input on the guidelines from stakeholders. This post […]

- Everything you need to know about the AI Act, for small and medium-sized enterprises (SMEs) in the EU and beyond.

- The Commission has opened two calls for expression of interest to recruit new members for the European AI Office. Apply now as Legal or Policy Officer for an opportunity to shape trustworthy AI. The deadline for expression of interest is 15 January 2025. The salary for this role is around €4100-8600 a month (limited taxes). […]

Referencias